미국 캘리포니아주가 대형 인공지능(AI) 기업에 안전 프로토콜 공개와 사고 보고를 의무화하는 법안을 재차 추진한다. 지난해 'SB 1047' AI 규제 법안이 거부된 이후 두 번째 시도로, 법적 책임은 제외하되 투명성 확보를 통해 신뢰 기반을 만들겠다는 계산이다.

10일 테크크런치에 따르면 스콧 위너 캘리포니아 주 상원의원은 AI 기업에 안전 대응 절차 공개와 사고 발생 시 보고 의무를 부과하는 'SB 53' 개정안을 발의했다. 이는 앞서 폐기된 'SB 1047' 법안의 수정판 성격으로, 기술 산업계와 정치권 간 충돌을 피하면서도 투명성 확보 요구를 유지한 형태다.

'SB 53'은 현재 주 의회 산하 '개인정보 및 소비자 보호 위원회'에 계류 중이다. 향후 여러 입법 절차를 거쳐 최종적으로 개빈 뉴섬 주지사의 서명을 받아야 한다.

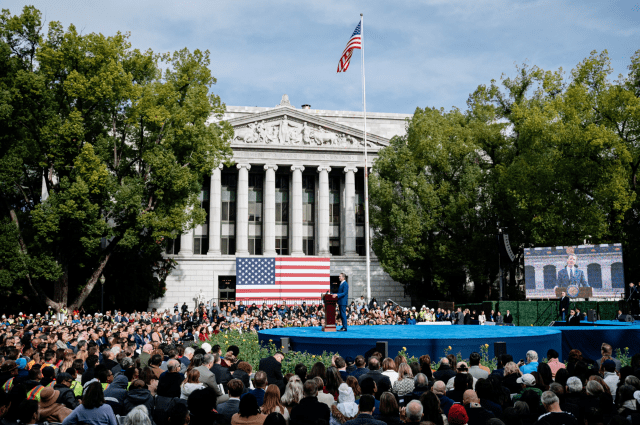

지난 2023년 취임식 선서를 하는 개빈 뉴섬 캘리포니아 주지사 (사진=위키 커먼스)

개정안에는 ▲대형 AI 기업의 안전·보안 대응체계 공개 ▲위험 상황 발생 시 보고서 제출 ▲내부 고발자 보호 제도 도입이라는 세 가지 핵심 조항이 담겼다. 특히 AI로 인한 '중대한 위험'에 대한 기준을 구체화해 사망 또는 부상자 100명 이상 혹은 10억 달러(한화 약 1조4천억원) 이상 피해가 발생할 경우로 정의했다.

또 하나의 주요 내용은 '캘컴퓨트(CalCompute)'라는 이름의 공공 고성능 클라우드 컴퓨팅 인프라 구축 계획이다. 대형 AI 모델 개발에 필수적인 연산 자원이 빅테크에 집중된 상황에서 자본력이나 인프라가 부족한 스타트업과 학계가 기술 경쟁에서 배제되지 않도록 하기 위한 조치다.

이와 병행해 'SB 53'은 기존 오픈소스 모델을 활용하거나 대형 모델을 파인튜닝만 하는 개발자들에 대해서는 규제 부담을 최소화하도록 설계됐다. 기술 접근권은 넓히되 규제 타깃은 대형 개발사로 한정하는 구조다.

더불어 이번 법안은 전작인 'SB 1047'과 달리 AI 모델이 초래한 피해에 대해 개발사에게 직접적인 법적 책임을 묻지 않는다. 대신 AI 기업이 수행 중인 위험 대응 조치와 내부 절차를 외부에 공개하게 함으로써 간접적 책임 구조를 유도하고 있다.

이번 개정안은 캘리포니아주 AI 정책자문그룹의 권고를 반영한 결과물이다. 해당 그룹은 페이페이 리 스탠퍼드대학교 교수를 중심으로 구성됐으며 최근 발표한 최종 보고서에서 시스템 정보의 의무적 공개가 신뢰 가능한 증거 기반 정책환경을 만드는 핵심 요소라고 명시했다. 위너 의원실은 이 권고가 'SB 53' 조항에 큰 영향을 미쳤다고 밝혔다.

페이페이 리 교수 (사진=스탠포드)

미국 연방 차원에서는 최근 AI 규제의 주정부 권한을 10년간 유예하는 법안이 검토됐으나 이달 초 상원에서 99대 1로 부결되며 무산됐다. 이에 따라 뉴욕주 등 다른 지역에서도 유사한 AI 규제 입법이 본격화되는 흐름이다.

업계 반응은 엇갈린다. 앤트로픽은 일정 수준의 투명성 확보 필요성을 인정하고 긍정적 입장을 보이고 있는데 비해 오픈AI, 구글, 메타 등은 여전히 조심스러운 태도를 유지하고 있다. 특히 최근 몇 달간 일부 대형 기업은 최신 모델 출시 후에도 안전 보고서를 공개하지 않아 책임 회피 논란을 자초한 바 있다.

일례로 구글은 '제미나이 2.5 프로' 모델을 발표한 이후 수개월 동안 안전 보고서를 제출하지 않았고 오픈AI 역시 'GPT-4.1'에 대한 공식 보고서를 생략했다. 이후 제3자 연구에서는 이 모델이 이전 버전보다 안전성 정렬 수준이 떨어진다는 분석도 나왔다.

관련기사

- 민주당, 김홍일 방통위원장 탄핵 추진..."6월내 통과 목표"2024.06.27

- 김홍일 위원장 "2인 체제 방통위, 바람직하지 않지만 위법 아니다”2024.06.21

- LG 구광모 6년...AI·바이오·클린테크 키운다2024.06.28

- 화재 막는 배터리 진단기술 뜬다...민테크, 상장 후 존재감 '쑥쑥'2024.06.28