카카오(대표 정신아)는 국내 공개 모델 중 최고 성능의 경량 멀티모달 언어모델과 혼합 전문가(MoE) 모델을 국내 최초 오픈소스로 공개한다고 24일 밝혔다

카카오는 허깅페이스를 통해 이미지 정보 이해 및 지시 이행 능력을 갖춘 경량 멀티모달 언어모델 ‘카나나(Kanana)-1.5-v-3b’와 MoE 언어모델 ‘카나나-1.5-15.7b-a3b’를 오픈소스로 선보였다. 지난 5월 공개한 언어모델 카나나-1.5 4종에 이어 두 달 만에 추가 모델을 오픈소스로 공개한 것이다.

정부가 추진하는 ‘독자 인공지능(AI) 파운데이션 모델 프로젝트’에 참여한 카카오는 이러한 자체 모델 개발 역량 및 카카오톡 등의 대규모 서비스 운영 경험 등을 토대로 전 국민의 AI 접근성을 높이고 국가 AI 경쟁력을 강화하는데 기여한다는 방침이다.

(사진=카나나)

이날 공개된 ‘카나나-1.5-v-3b’는 텍스트 뿐만 아니라 이미지 정보도 처리할 수 있는 멀티모달 언어모델로, 지난 5월 말 오픈소스로 공개한 카나나 1.5 모델을 기반으로 하고 있다. 카나나 1.5는 모델 개발의 처음부터 마지막 단계까지 카카오의 자체 기술을 바탕으로 구축하는 ‘프롬 스크래치’ 방식으로 개발됐다.

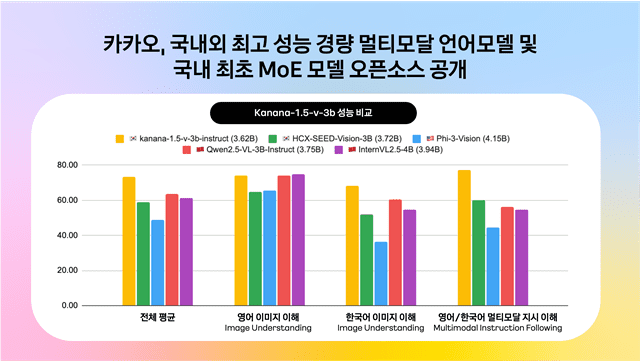

멀티모달 언어모델인 ‘카나나-1.5-v-3b’는 이용자의 질문 의도를 정확히 이해하는 높은 지시 이행 성능과 뛰어난 한국어·영어 이미지 이해 능력을 보유했다고 회사 측은 설명했다.

또한, 한국어 벤치마크에서 유사 사이즈의 국내외 공개 모델과 비교한 결과 최고 점수를 기록했고 다양한 영어 벤치마크에서 해외 오픈소스 공개모델과 비교했을 때도 유사한 수준의 성능을 보인 것으로 알려졌다. 지시 이행 능력 벤치마크에서는 국내 공개된 유사한 규모의 멀티모달 언어모델 대비 128% 수준의 성능을 기록했다.

카카오는 인간 선호 반영 학습과 지식 증류를 통해 ‘카나나-1.5-v-3b’의 성능을 극대화했다. 지식 증류는 고성능의 대형 모델로부터 비교적 작은 모델을 학습하는 방식이다. 단순한 정답 뿐 아니라 대형 모델의 예측 확률 분포까지 학습에 반영함으로써 작은 모델이 더 정교하고 일반화된 예측 능력을 갖추도록 돕는 기술이다. 이를 통해 상대적으로 경량화된 모델 구조임에도 정확도나 언어 이해 등의 능력에서 대형 모델의 높은 성능에 근접하거나 이를 뛰어 넘을 수 있는 능력을 발휘하도록 돕는다.

‘카나나-1.5-v-3b’는 경량 멀티모달 언어모델의 강점을 토대로 ▲이미지 및 글자 인식 ▲동화 및 시 창작 ▲국내 문화유산 및 관광지 인식 ▲도표 이해 ▲수학 문제풀이 등 여러 분야에서 활용할 수 있다.

예를 들어, 장소 사진과 함께 이 사진이 촬영된 장소에 대해 간단히 설명해줘라고 질문하면 “이 사진은 서울 청계천을 배경으로 하고 있습니다”와 같이 국내 지역에 대한 인식력을 바탕으로 정확한 답변을 제공한다.

카카오는 모델의 성능에 집중하는 단계를 넘어 AI가 사람처럼 생각하고 행동할 수 있는 ▲멀티모달 이해 능력 ▲사용자 지시 수행 능력 ▲추론능력을 갖추도록 발전시키는 데 주력하고 있다. 하반기 중에는 에이전트형 AI 구현에 필수적인 추론 모델의 성과도 공개할 예정이다.

카카오는 일반적인 ‘밀집’ 모델과 차별화되는 MoE 구조의 언어모델도 오픈소스로 함께 공개했다. ‘MoE’는 입력 데이터 처리 시 모든 파라미터가 연산에 참여하는 기존 모델과 달리 특정 작업에 최적화된 일부 전문가 모델만 활성화되는 방식으로 효율적인 컴퓨팅 자원 활용과 비용 절감이 특징이다.

MoE 아키텍처를 적용한 ‘카나나-1.5-15.7b-a3b’는 전체 15.7B의 파라미터 중 추론 시 약 3B 파라미터만 활성화돼 동작한다. 카카오는 모델의 학습 시간과 비용을 절약하기 위해 자사의 3B 규모의 모델 ‘카나나-Nano-1.5-3B’에 ‘업사이클링’ 방식을 적용해 개발했다. 업사이클링은 기존 다층 신경망(MLP) 레이어를 복제해 여러 전문가 레이어로 변환하는 방식으로 모델을 처음부터 개발하는 방식에 비해 효율적이다. 활성화되는 파라미터가 3B에 불과하지만 성능은 ‘카나나-1.5-8B’와 동등하거나 상회하는 수준을 기록했다.

카카오의 MoE 모델은 고성능 AI 인프라를 저비용으로 구축하고자 하는 기업이나 연구 개발자들에게 실용적인 도움을 제공할 수 있다는 설명이다. 특히 추론 과정에서 제한된 파라미터만 사용하는 구조적 특성 덕분에 저비용, 고효율 서비스 구현에 유리하다.

카카오는 이번 경량 멀티모달 언어모델과 MoE 모델의 오픈소스 공개를 통해 AI 모델 생태계에 새로운 기준을 제시하고 더 많은 연구자와 개발자가 강력한 AI 기술을 자유롭게 활용할 수 있는 기반을 마련해 갈 계획이다. 뿐만 아니라 자체 기술 기반의 모델을 지속적으로 고도화하고 모델 스케일업을 통해 글로벌 플래그십 수준의 초거대 모델 개발에 도전함으로써 국내 AI 생태계의 자립성과 기술 경쟁력 강화에 기여할 계획이다.

김병학 카카오 카나나 성과리더는 “이번 오픈소스 공개는 비용 효율성과 성능이라는 유의미한 기술 개발의 성과를 거둔 것으로 단순한 모델 아키텍처의 진보를 넘어 서비스 적용과 기술 자립이라는 두 가지 측면의 목표에 부합하는 결과물”이라고 말했다.

박서린 기자psr1229@zdnet.co.kr

기자의 다른 기사 보기

카카오

카나나

멀티모달

AI

오픈소스

MOE

경량

언어모델

sLLM

(function(d,a,b,l,e,_) {

if(d[b]&&d[b].q)return;d[b]=function(){(d[b].q=d[b].q||[]).push(arguments)};e=a.createElement(l);

e.async=1;e.charset='utf-8';e.src='//static.dable.io/dist/plugin.min.js';

_=a.getElementsByTagName(l)[0];_.parentNode.insertBefore(e,_);

})(window,document,'dable','script');

dable('setService', 'zdnet.co.kr');

dable('sendLogOnce');

dable('renderWidget', 'dablewidget_Ylj6jNlO');

jQuery(function(){

$("img.lazy").show().lazyload();

window.onload = function() {

$(window).resize()

};

});

jQuery(document).ready( function() {

$("img.lazyload").lazyload();

$('.fb-share').click(function(e) {

e.preventDefault();

window.open(encodeURI($(this).attr('href') + $(this).attr('aria-label')), 'fbShareWindow', 'height=450, width=550, top=0, left=0, toolbar=0, location=0, menubar=0, directories=0, scrollbars=0');

return false;

});

$('.fb2-share').click(function(e) {

e.preventDefault();

window.open($(this).attr('href') + $(this).attr('aria-label'), 'fbShareWindow', 'height=450, width=550, top=0, left=0, toolbar=0, location=0, menubar=0, directories=0, scrollbars=0');

return false;

});

$(window).scroll(function() {

const indexSections = document.querySelectorAll('b');

let screenCenter = (document.documentElement.clientHeight / 2);

indexSections.forEach((section) => {

const targetElement = section;

var blockqt = targetElement.parentElement.parentElement;

if (blockqt.nodeName == 'blockquote' || blockqt.nodeName == 'BLOCKQUOTE') {

return;

}

const targetOffset = section.getBoundingClientRect().top;

if (screenCenter > targetOffset) {

targetElement.classList.add('on');

} else {

//targetElement.style.className = '';

}

});

});

});

#articleBody p b {

background-image: -webkit-gradient(linear,left top,right top,color-stop(50%,transparent),color-stop(0,rgba(144 217 106 / 40%)));

background-image: linear-gradient(90deg,transparent 50%,rgba(144 217 106 / 40%) 0);

background-position: 0;

background-size: 200%;

-webkit-transition: background-position 1s linear;

transition: background-position 1s linear

}

#articleBody p b.on {

background-position: -100%

}

.c-sitePrimaryMenu_text a {color: #fff;}

.c-siteMenuList_item a {color:#fff;}

window.livereOptions ={

refer: 'zdnet.co.kr/view/?no=20250724103045',

eagerLoading: true

};

window.livereHooks = {

created: function (data) {

jQuery('#comment_box').css('height', '0px');

}

};

(function(d,s) {

var j, e=d.getElementsByTagName(s)[0];

if (typeof LivereTower === 'function') {return;}

j=d.createElement(s);

j.src='https://cdn-city.livere.com/js/embed.dist.js'; j.async=true;

e.parentNode.insertBefore(j,e);

})(document,'script');

라이브리 댓글 작성을 위해 javascript를 활성화해 주세요

지금 뜨는 기사

이시각 헤드라인

차세대 HBM용 하이브리드 본더 시장 커진다

줄줄이 회생 신청한 유통업계…M&A 마저 ‘빨간불’

표류하는 '국가AI컴퓨팅센터' 사업, 삼성SDS 발언에 동력 붙나

립부 탄 인텔 CEO "파운드리 백지수표 투자는 끝"

ZDNet Power Center

Connect with us

ZDNET Korea is operated by Money Today Group under license from Ziff Davis. Global family site >> CNET.com | ZDNet.com

ZDNet Korea Newsletter 구독 신청

구독신청

회사소개

광고문의

DB마케팅문의

제휴문의

개인정보처리방침

이용약관

청소년 보호정책

회사명 : (주)메가뉴스

제호 : 지디넷코리아

등록번호 : 서울아00665

등록연월일 : 2008년 9월 23일

사업자 등록번호 : 220-87-44355

주소 : 서울시 마포구 양화로111 지은빌딩 3층

대표전화 : (02)330-0100

발행인 : 김경묵

편집국장 : 김태진

개인정보보호 책임자·청소년보호책임자 : 김익현

COPYRIGHT © ZDNETKOREA ALL RIGHTS RESERVED.

$(document).ready(function(){

var searchbtn = document.getElementById('searchTrigger');

searchbtn.addEventListener('click', function () {

if($('#searchTrigger').hasClass('is-expanded')){

setTimeout(function(){$('#kwd').focus();},10);

}

});

});

if(!wcs_add) var wcs_add = {};

wcs_add["wa"] = "12259f69c80da30";

if(window.wcs) {

wcs_do();

}

관련기사

- 민주당, 김홍일 방통위원장 탄핵 추진..."6월내 통과 목표"2024.06.27

- 김홍일 위원장 "2인 체제 방통위, 바람직하지 않지만 위법 아니다”2024.06.21

- LG 구광모 6년...AI·바이오·클린테크 키운다2024.06.28

- 화재 막는 배터리 진단기술 뜬다...민테크, 상장 후 존재감 '쑥쑥'2024.06.28